測定されたデータをもとにして母集団を比較するときには2種類の誤りが生じる可能性があります。

- 第1種過誤(αエラー):本当は差がないのに「差がある」と判断してしまう誤り

- 第2種過誤(βエラー):本当は差があるのに「差がない」と判断してしまう誤り

エラーをどの程度まで許容するかは状況によって異なりますが、臨床研究ではαエラーを5%まで許容していることが多いです(有意水準のことです)。

1つの疑問に答えるために仮説検定を複数回行うと、個々の検定でのαエラーは5%未満であっても、全体では5%を超えてしまっていることがあります。これに基づいて結論を下すと、誤った判断をしている確率が想定しているよりも高くなってしまいます。このことは「多重比較の問題」とか「検定の多重性」とか呼ばれたりします。

ここでは多重比較について学んだことを記事にしたいと思います。

多重比較補正方法

例えば、薬剤A, B, Cがあって、これらの薬剤の効果を比較するとします。どの治療が優れているかペアを作って比較する場合、

- $H_0$:A = B

- $H_0$:B = C

- $H_0$:C = A

の3つの帰無仮説について検定することになります。個々の仮説検定におけるαエラーを、individual error rate(IER)とかper comparison error rate(PCER)とか呼んだりするようです。

この3つの検定は「薬剤A, B, Cの効果は全て等しい」という、より大きな仮説を構成しています。同時に考慮されるべき複数の仮説から構成される仮説群を、帰無仮説族(famiy of hypotheses)と呼びます。

帰無仮説族のαエラーを制御するために用いられる方法はいくつか提唱されていますが、「何をαエラーの基準として制御するか」によって大きく2つに分けられます。

以後、下の表*1を使って2つのアプローチで基準にしている指標を説明します。これはm個の仮説検定について、$H_0$の真偽、つまり本当は差がないのか($H_0$が真)、本当は差があるのか($H_0$が偽)なのかと、検定における有意差の有無を表しています。$H_0$が真にもかかわらず、検定で有意差が出てしまったV個の仮説検定については、偽陽性ということになります。

FWERを制御するアプローチ

Family-wise error rate(FWER)は仮説族のうち1つでも偽陽性になってしまう確率 です。表中の文字を使って表すと、次のように書けます。

$$ FWER = P(V \geq1) $$

ちなみに個々の検定でのαエラー(先程IERとかPCERとか呼んだもの)は、

$$ IER = E\left[ \frac{V}{m} \right] $$

と書けます。FWERアプローチの代表であるBonferroni法は、IERをα/mに抑えれば、FWERはα以下になることが保証される性質を利用したものです。Bonferroni法の低い検出力を補うべく開発された方法としては、Holm法、Hochberg法、Hommel法があります。

FDRを制御するアプローチ

False discovery rate(FDR)は、棄却した仮説(有意差があったもの)の中で、棄却が誤っていた(本当は差がなかった)確率 です。 表中の文字を使うと、

$$ FDR = E\left[ \frac{V}{R} \right] $$

となります。臨床の検査で言えば、「検査で陽性と判断したのに実際は病気は存在していなかった割合(= 陽性「非」的中率)」です。

FWER vs FDR

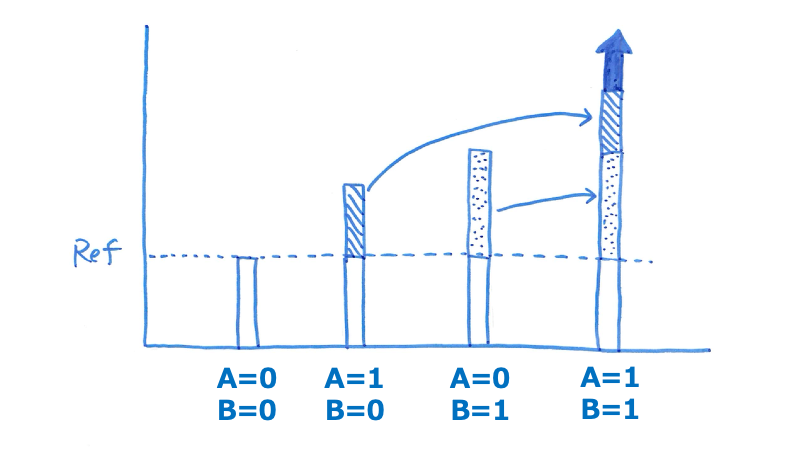

FWERアプローチは「偽陰性が増えても(つまり検出力が落ちても)、偽陽性は避けたい」という手法です。仮説族のうち1つでも誤っていると結論に影響するような場合に用います。

これに対しFDRアプローチは「真の効果を検出する確率を向上させるためなら、多少の偽陽性結果は許容する」という手法です。

例えば有効な薬剤を探すため、まずは可能性のある物質を絞って、次のフェーズで効果を検証したいときはFDRアプローチは良い方法です。この状況だと、スクリーニングで落としてしまうと効果の検証に回らないので、多くの可能性を拾い上げたいからです(ただ、拾い上げすぎると次のフェーズで負担が増えます)。

他にも、複数のエンドポイントを総合的に判断して、どちらが有効な治療か決定したいときは、1つのエンドポイントで偽陽性になったとしても、全体の中の割合が許容できる範囲なら、最終的な決定には影響がないかもしれません。この場合もFDRアプローチの方が有利です。

偽陽性・偽陰性のどちらに重みを置くかは、個々の研究で慎重に判断した方がいいでしょう。

そもそも多重性補正が必要か

複数の仮説検定を実施したからといって、常に多重性の補正が必要な訳ではありません。 今回参考にしたJAMA Guide to Statistics and Methodsによると、仮説検定に基づいて答えを出したいリサーチクエスチョン(RQ)との関係性が重要なようです。すなわち、複数の仮説が1つのRQに対するものであれば補正が必要ですし、複数の仮説が、それぞれ無関係なRQに対するものであれば補正不要です。

また、検証的仮説(=事前に設定された仮説)は最終的に何かの決定を下すための判断材料を提供することが目的なので、補正が必要な状況では補正をすべきです(しかも事前に決めた方法で)。これに対し、事前に仮説を設定していない探索的仮説では必ずしも多重性補正を必要としませんが、統計学的に有意な差が認められた結果について、読者が科学的な重要性を正しく判断できるように配慮すべきです。

A, B, Cの3群を比較するときに、B vs. Cの比較に興味がなければ「2つの仮説(A vs. B, A vs. C)についてのみ補正する」というスタンスでも構いません。ただし、あくまで事前に決めてあることが前提です。結果を見て「3つの対比較を補正すると有意差でないけど2つならギリギリ有意差が出るから」というのはもちろんダメです。

Rで実行する方法

カテゴリー変数の多重比較

以前、カテゴリー変数の多重比較補正について書きました。代表的なFWERアプローチ(Bonferroni法, Holm法, Hochberg法)については、実際にどのような計算がされているかも確認しました。

使用できる補正方法については、後に登場するp.adjust( )の説明を参照してください(内部でp.adjustが使われているので)。

連続変数の多重比較

A, B, C群に10例ずつ割り当てられて得られたデータx_contを比較する方法を示します。

x_cont <- rnorm(n=30, mean=0, sd=10) group <- rep(c("A", "B", "C"), 10)

t検定を使う場合は、pairwise.t.test( )を使います。

pairwise.t.test(x=x_cont, g=group, p.adjust.method = "bonferroni", pool.sd = FALSE)

p.adjust.method:後述のp.adjust( )の説明を参照pool.sd:Welchのt検定を使うときはFALSE, Studentのt検定を使うときはTRUE

出力は次のようになります。

Pairwise comparisons using t tests with non-pooled SD data: x_cont and group A B B 1.000 - C 0.484 0.095 P value adjustment method: bonferroni

Mann-Whitney U検定を使う場合は、pairwise.wilcox.test( )を使います。

pairwise.wilcox.test(x=x_cont, g=group, p.adjust.method = "bonferroni")

P値だけを使って多重比較補正する

前述の方法に上手く当てはめられないケースでも、個々の仮説検定のP値が得られていれば補正は可能です。p.adjust( )を使います。

例えば、

p <- runif(n=10, min=0.01, max=0.1)

でランダムに作られたP値

> p [1] 0.04351779 0.02973471 0.02640490 0.03786525 0.03460761 0.02104036 [7] 0.08782673 0.05836001 0.03028355 0.01085827

を、Holm法で補正すると次のようになります。

> p.adjust(p, method = "holm") [1] 0.2112392 0.2112392 0.2112392 0.2112392 0.2112392 0.1893633 0.2112392 [8] 0.2112392 0.2112392 0.1085827

用いることができる補正方法は以下のとおりです(引用文献は?p.adjustで表示されるヘルプを参照ください)。

- FWERアプローチ:

"holm","hochberg","hommel","bonferroni" - FDRアプローチ:

"BH","BY","fdr"(="BH"と同じ)

おわりに

- やはりフェアなスタンスで事前に決めておく方が査読対応でもスッキリするように思います。

- コロナ禍でのペット需要増を反映してか、ペット保険会社の業績が好調なようです。我が家も入ってますが、利用する機会がありませんように。

参考資料

- Yoav Benjamini and Yosef Hochberg. Controlling the False Discovery Rate: A Practical and Powerful Approach to Multiple Testing. Journal of the Royal Statistical Society. Series B (Methodological), 1995, Vol. 57, No. 1 (1995), pp. 289-300

*1:参考資料に挙げたBenjamini(1995)を元に作成しました