この記事では回帰モデルが満たすべき前提条件のうち、「線形性」について評価する方法について学んでみるつもりです。回帰モデルの満たすべき仮定の概要については以下の記事を参考にしてください。

線形性(linearity)の仮定とは

線形性とは、

(→ 2つの数値の和を入力したときの出力は、それぞれの値を入力したときの出力の和になる)

(→ 入力をa倍にすると、出力もa倍になる)

という性質のことです。

回帰モデルでは、アウトカムYに対する各説明変数Xの影響が「直線の式」、つまり

のようになっていることです。 「直線の式」と表現しましたが、Xの1次式である必要はありません。例えば、

のように、べき乗・平方根・対数のような変換があったとしても、

変換後のXを新しい変数 と置き換えてしまえば、全て下のようになります。

変換したらOKだったらどんなモデルも線形モデルになりそうですが、下のモデルは非線形モデルです。

他にも、加算的であるべき2つの変数の効果に交互作用があると線形性を満たしません。

個人的には説明変数Xに注目するよりも、係数βに注目する*1方が「線形性の仮定」が理解しやすいのではないかと思っています。

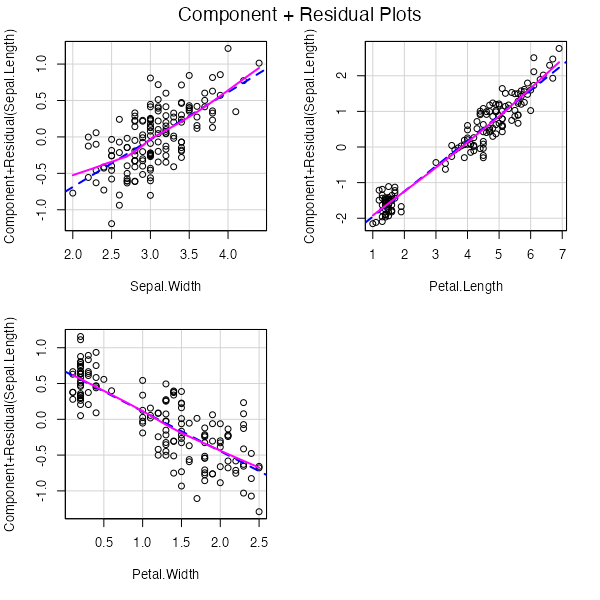

Component + Residual Plot(C+R plot)

別名 partial residual plotとも呼ばれます。Partial residual(PR)は次のように定義されます(ここで説明変数は ,

の2つだと思ってください)。

ここで、 は全ての説明変数を使った線形回帰モデルの残差です。

真の関係性が

であるとすると、

最後の式は ,

から導かれます。もし

について線形性から大きくかけ離れていたとしても、

と

はそれほど大きくは違わないだろう、ということだそうです(多分)。

変数 に対して

をプロットしたものがC+R plotで、

について線形性が成り立っていればプロットは直線になります。

crPlots( )を使ってC+R plotを描く

まず、irisデータで線形回帰モデルを当てはめます。

fit <- lm(Sepal.Length ~ Sepal.Width + Petal.Length + Petal.Width, data = iris)

carパッケージを読み込んで、当てはめたモデルをcrPlots( )に渡します。

library(car) crPlots(fit)

青い点線がそれぞれの変数の係数βを傾きとした直線、ピンクの実線が実際のプロットを局所回帰した曲線です。プロットを見ると、いずれの変数に対しても線形性が仮定できそうです。

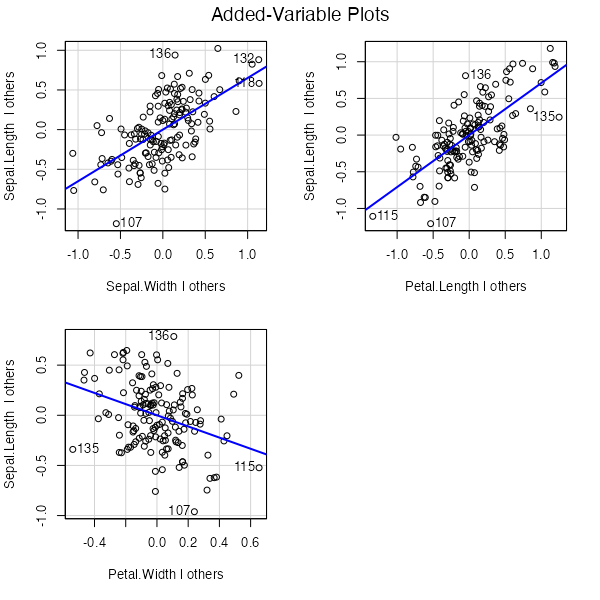

Added-Variable Plot(AV plot)

Partial regression plotとも呼ばれるようです。変数 についてのAV plotは、次の2つをx軸, y軸にとってプロットしたものです。

- y軸:アウトカム

を

を除いた変数で回帰したときの残差

- x軸:説明変数

を

を除いた変数で回帰したときの残差

このプロットの傾きが0(= 水平)であれば、「他の変数が含まれている状態では変数 によって追加される情報はない」ということになります。プロットの様子(曲がり具合)からどのように変数変換したらいいかを判断することに使いたくなりますが、あくまで「この変数を追加して意味があるか」が分かるだけで、線形性については判断できないとのこと。(なので厳密には線形性の評価方法とは言えないようです。)

avPlots( )を使ってAV plotを描く

同じくcarパッケージに含まれているavPlots( )に当てはめたモデルを渡します。

avPlots(fit)

いずれの変数についてもプロットが水平ではないので、モデルに含めて意味がありそうです。

おわりに

- GLMにも拡張できるそうです。

- 2匹目の保護猫を迎えてちょうど1年になりました。当初は先住猫と色々あって、本当にお迎えしてよかったのか悩みましたが、そのことも今となってはいい思い出です。

参考資料

- Applied linear statistical models(5th edition)

- AV plotについては多く説明されていますが、C+R plotは参考文献を参照という記載のみでした。

- Regression Graphics: Added-Variable and Component+Residual Plots As Implemented in the car and effects packages for R

- CANSSI Statistical Software Conference 2022でのレクチャースライドでしょうか。最初に読みました。大変分かりやすかったです。

- Fox J, Weisberg S. Visualizing Fit and Lack of Fit in Complex Regression Models with Predictor Effect Plots and Partial Residuals. J. Stat. Soft. 2018;87(9):1-27.

- R.Dennis Cook. Exploring Partial Residual Plots, Technometrics. 1993; 35:4, 351-362

- Partial residual plotについては、まずこれを読むと全体像が見えやすいかもしれません。

- R.Dennis Cook. Added-variable plots and curvature in linear regression. Technometrics. 1996; 38:3, 275-278

*1:それぞれのβで偏微分したらどうなるか