測定の信頼性(reliability)とは、反復して測定したときにどれくらい安定して同じ測定値が返ってくるかということ。 相関係数(correlation coefficient)で評価するのは不適切*1で、代わりに級内相関係数(intraclass correlation coefficient, ICC)を使う必要あり。 ただ、ICCにはいくつか型(form)があって、表記方法も完全に統一されている訳ではないのでちょっとややこしい。

McGraw & Wongの提唱する10種類のICC

McGraw & Wong(1996)では次の3項目に基づいて10種類のICCを定義している。

- Model:以下の3つのモデルがある。

- One-way random-effects model:各被験者(subject)が異なった検査者(rater)の評価しか受けない場合。多施設共同研究で物理的に同じraterが全てのsubjectを評価できない状況など。信頼性評価で用いられることは稀。

- Two-way random-effects model:大きいraterの集団からランダムにraterを選んできた場合。再現性の結果を同じ特性を持ったraterに一般化したいときに用いる。

- Two-way mixed-effects model:選ばれた特定のraterにのみ興味があり一般化することは考えていない場合。Two-way random-effects modelよりも用いられることは少ない。

- Type:数値が完全に一致していることを求めるか(absolute agreement)、raterごとに系統的な差があることは許容するか(consistency)の違い。後者の方が高くなる。

- Unit:1回の測定値の信頼性を見るのか(single rater)、複数回の測定の平均値の信頼性を見るのか(means of k raters)の違い。後者の方が高くなる。

Shrout & Fleiss(1979)では6種類のICCの型を定義しているが、McGraw & Wongの方が全体が整理できて分かりやすいと思う(対応は表1のとおり)。

- One-way random-effects modelではraterがsubjectごとに違うのでconsitencyは評価できない。

- "Definition"が同じであればtwo-way random-effects modelとtwo-way mixed-effects modelは同じ値になる(研究デザインと解釈に違いがあるだけ)。

信頼性評価の目的による分類とICCの選び方

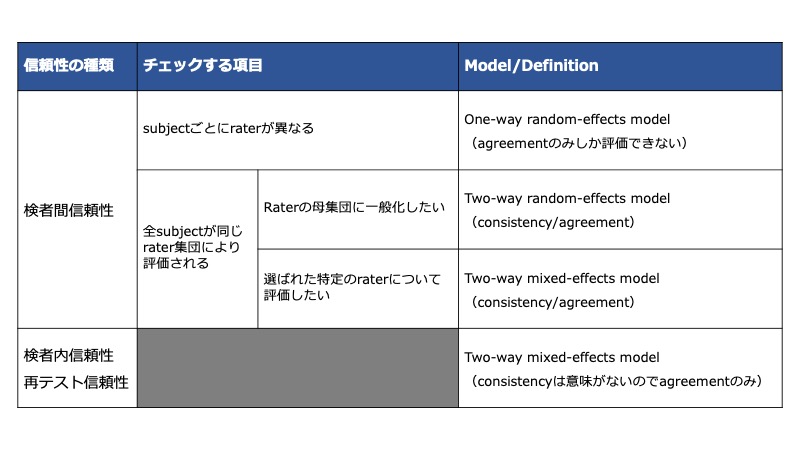

信頼性評価は目的によって次のように分類される。

- 検者間信頼性(interrater reliability):複数のraterが同一subjectを測定して、どれくらい一致するか

- 再テスト信頼性(test-retest reliability):同じsubjectを同時期に測定して、どれくらい一致するか。自己回答式調査や機器による測定のような、raterが関与しない(あるいはrater effectが無視できる)状況での信頼性評価に用いる。

- 検者内信頼性(intrarater reliability):1人のraterが複数の測定でどれくらい一致するか。

それぞれの場合のICCの選び方は次のとおり。

ICCの解釈の目安

次のとおり。

- <0.5:poor

- 0.5-0.75:moderate

- 0.75-0.9:good

0.9:excellent

例えば信頼性がgoodかどうかを判断するためには、

- ICCの信頼区間の下限が0.75以上

- H1:ICC>0.75を対立仮説とした検定のP値

などで判断する。

ちなみに、信頼性を評価する研究を行うときは30 subjects, 3 ratersを用意することが目標とのこと。

icc( )でICCを計算する

irrパッケージではMcGraw & Wongの定義に従ってICCのformを指定するので分かりやすかった。

ここではanxietyというサンプルデータを使ってみる。

> library(irr) > data(anxiety) > head(anxiety) rater1 rater2 rater3 1 3 3 2 2 3 6 1 3 3 4 4 4 4 6 4 5 5 2 3 6 5 4 2

subjectが行、各raterが列になるようにデータを準備する。

以下の引数を指定。

model:onewayまたはtwowayを指定(two-way random-effectsとtwo-way mixed-effectsはtypeが同じなら同じものなので区別しなくてよい)。type:consistencyまたはagreementを指定。unit:singleまたはaverageを指定r0:帰無仮説がICC=r0, 対立仮説がICC>r0の片側検定を行う(検定のときに使うICCの基準値)conf.level:信頼区間の水準

icc(anxiety, model="twoway", type="agreement", unit="single", r0=0.5, conf.level = 0.95)

Single Score Intraclass Correlation Model: twoway Type : agreement Subjects = 20 Raters = 3 ICC(A,1) = 0.198 F-Test, H0: r0 = 0.5 ; H1: r0 > 0.5 F(19,39.7) = 0.42 , p = 0.977 95%-Confidence Interval for ICC Population Values: -0.039 < ICC < 0.494

おわりに

- ややこしいICCも「どんな信頼性を評価したいのか」を元に選べばスッキリしそう。

- 明け方になるとネコが起こしにくるので寝不足です。

参考資料

- McGraw KO, Wong SP. Forming inferences about some intraclass correlation coefficients. Psychol Methods. 1996;1:30–46.

- Shrout PE, Fleiss JL. Intraclass correlations: uses in assessing rater reliability. Psychol Bull. 1979 Mar;86(2):420-8.

- Koo TK, Li MY. A Guideline of Selecting and Reporting Intraclass Correlation Coefficients for Reliability Research. J Chiropr Med. 2016 Jun;15(2):155-63.)

- George M. Harrison University of Hawai‘i at Mānoa, C., 2021. Chapter 10 Inter-rater and Test-retest Reliability | Using R for Measurement in the Social Sciences.

- irrパッケージの説明書 [PDF]

*1:身長と体重は測定値が全然違っても、相関係数は高いことからも分かる